近些年,关于时间序列、自然语言处理等任务大家一般都会想到RNN、LSTM、GRU,一维CNN以及后面延伸出的Bi-Lstm、ConvLstm等等,这是因为RNN天生可以记住以前时段的信息,而传统的神经网络并不具有这个功能。卷积神经网络和循环神经网络作为深度学习的两大支柱,已近被越来越多的学者进行研究。在最近的研究之中,特定的卷积神经网络结构也可以达到很好的效果,比如Goolgle提出的用来做语音合成的wavenet,Facebook提出的用来做翻译的卷积神经网络。这就体现出经过特定设计的卷积神经网络在处理时间序列的任务上也具有巨大的发展潜力,本文就介绍一种特殊的卷积神经网络————时空卷积神经网络(Temporal convolutional network,TCN)。

TCN的表现:

- TCN与其他网络结构相比具有更长的记忆。

- 与LSTM/GRU相比,在很多任务上已经表现出更好的效果。

- 拥有并行的卷积层、灵活大小的卷积核、稳定的梯度。

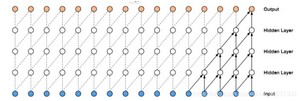

2.1 因果卷积网络

所谓因果卷积网络是指,上一层t时刻的值只能依赖于下面那层t时刻以及t时刻之前的值,与传统的神经网络不同,TCN不能看见未来的数据,只有前面的因才有后面的果。

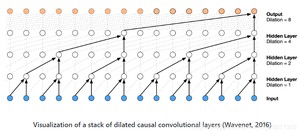

2.2 膨胀卷积方式

膨胀卷积是指卷积的Dilation的大小,也就是卷积的采样间隔大小,通过增加采样间隔的大小,使得网络在较少的层数下就可记住较多以前的信息,一般来说,越高的层使用的Dilation越大。

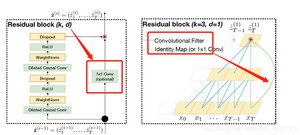

2.3 残差块

残差块最开始是用来处理由于神经网络层数过多而出现的网络效果退化的情况。残差神经网络被证明是训练深度网络较好的方法。如上图所示,一个残差块包含两层的卷积和非线性映射,在每层中还加入了WeightNorm和Dropout来正则化网络。

这个文件主要是做数据归一化操作的

TCN网络的构建

运行效果

链接: github项目.

链接: TCN博客.

链接: TCN博客.

链接: TCN博客.

版权声明:

本文来源网络,所有图片文章版权属于原作者,如有侵权,联系删除。

本文网址:https://www.mushiming.com/mjsbk/3640.html