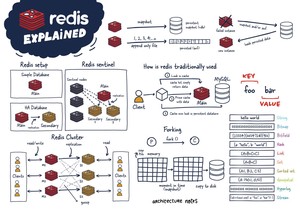

Redis 是一个开源(BSD许可)的,内存中的数据结构存储系统,它可以用作数据库、缓存和消息中间件。 它支持多种类型的数据结构,如 字符串(strings), 散列(hashes), 列表(lists), 集合(sets), 有序集合(sorted sets) 与范围查询, bitmaps, hyperloglogs 和 地理空间(geospatial) 索引半径查询。 Redis 内置了 复制(replication),LUA脚本(Lua scripting), LRU驱动事件(LRU eviction),事务(transactions) 和不同级别的 磁盘持久化(persistence), 并通过 Redis哨兵(Sentinel)和自动 分区(Cluster)提供高可用性(high availability)。

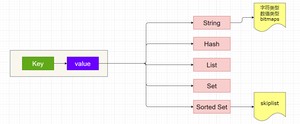

Redis是基于内存的数据储存服务,它支持key-value查询操作,value存在以下五种数据类型

- 字符串(strings)

- 散列(hashes)

- 表(lists)

- 集合(sets)

- 有序集合(sorted sets)

地址:http://download.redis.io/releases/

进入解压的目录,运行make命令

Redis 字符串数据类型的相关命令用于管理 redis 字符串值,常用操作命令如下:

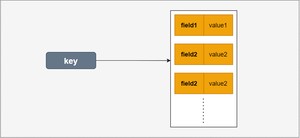

hash 是一个 string 类型的 field(字段) 和 value(值) 的映射表,hash 特别适合用于存储对象

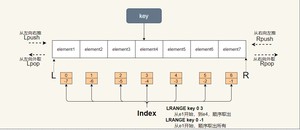

Redis列表是简单的字符串列表,按照插入顺序排序。你可以添加一个元素到列表的头部(左边)或者尾部(右边)

有序集合和集合一样也是 string 类型元素的集合,且不允许重复的成员。

不同的是每个元素都会关联一个 double 类型的分数。redis 正是通过分数来为集合中的成员进行从小到大的排序。

有序集合的成员是唯一的,但分数(score)却可以重复

HyperLogLog 是用来做基数统计的算法,HyperLogLog 的优点是,在输入元素的数量或者体积非常非常大时,计算基数所需的空间总是固定 的、并且是很小的。

在 Redis 里面,每个 HyperLogLog 键只需要花费 12 KB 内存,就可以计算接近 2^64 个不同元素的基 数。这和计算基数时,元素越多耗费内存就越多的集合形成鲜明对比。

但是,因为 HyperLogLog 只会根据输入元素来计算基数,而不会储存输入元素本身,所以 HyperLogLog 不能像集合那样,返回输入的各个元素。

比如数据集 {1, 3, 5, 7, 5, 7, 8}, 那么这个数据集的基数集为 {1, 3, 5 ,7, 8}, 基数(不重复元素)为5。 基数估计就是在误差可接受的范围内,快速计算基数。

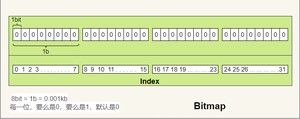

bitmap就是通过最小的单位bit来进行0或者1的设置,表示某个元素对应的值或者状态。

一个bit的值,或者是0,或者是1;也就是说一个bit能存储的最多信息是2。

RDB持久化方式能够在指定的时间间隔能对你的数据进行快照存储.

AOF持久化方式记录每次对服务器写的操作,当服务器重启的时候会重新执行这些命令来恢复原始的数据,AOF命令以redis协议追加保存每次写的操作到文件末尾.Redis还能对AOF文件进行后台重写,使得AOF文件的体积不至于过大.

如果你只希望你的数据在服务器运行的时候存在,你也可以不使用任何持久化方式.

你也可以同时开启两种持久化方式, 在这种情况下, 当redis重启的时候会优先载入AOF文件来恢复原始的数据,因为在通常情况下AOF文件保存的数据集要比RDB文件保存的数据集要完整.

RDB是redis默认开启的持久化方式

当 Redis 需要保存 dump.rdb 文件时, 服务器执行以下操作:

- Redis 调用forks. 同时拥有父进程和子进程。

- 子进程将数据集写入到一个临时 RDB 文件中。

- 当子进程完成对新 RDB 文件的写入时,Redis 用新 RDB 文件替换原来的 RDB 文件,并删除旧的 RDB 文件。

这种工作方式使得 Redis 可以从写时复制(copy-on-write)机制中获益,与AOF相比,在恢复大的数据集的时候,RDB方式会更快一些.

RDB是一个非常紧凑的文件,它保存了某个时间点得数据集,非常适用于数据集的备份,比如你可以在每个小时报保存一下过去24小时内的数据,同时每天保存过去30天的数据,这样即使出了问题你也可以根据需求恢复到不同版本的数据集.

在命令行里,可以通过 或 ,命令来手动立刻触发生成内存快照

AOF 重写和 RDB 创建快照一样,都巧妙地利用了写时复制机制:

- Redis 执行 fork() ,现在同时拥有父进程和子进程。

- 子进程开始将新 AOF 文件的内容写入到临时文件。

- 对于所有新执行的写入命令,父进程一边将它们累积到一个内存缓存中,一边将这些改动追加到现有 AOF 文件的末尾,这样样即使在重写的中途发生停机,现有的 AOF 文件也还是安全的。

- 当子进程完成重写工作时,它给父进程发送一个信号,父进程在接收到信号之后,将内存缓存中的所有数据追加到新 AOF 文件的末尾。

- 搞定!现在 Redis 原子地用新文件替换旧文件,之后所有命令都会直接追加到新 AOF 文件的末尾。

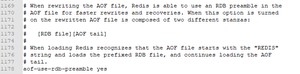

AOF吸取RDB的优点,在第一次使用AOF的时候,

在redis的配置文件中,大概1000多行的位置,有一个描述

redis的AOF持久功能,实际是结合了rdb的功能的,在首次进行AOF追加的时候,会将内存现有的数据以RDB快照的形式储存在aof文件的开始位置,然后如果有追加,就会在AOF文件中将command加入到末尾。

也可以通过命令,将redis现在的数据,以RDB快照的形式重写进aof文件中,并覆盖aof文件中原有的数据(命令记录就消失,只有rdb快照,文件变小了))。

存有rdb快照的aof文件内容如下:

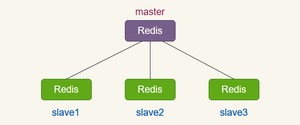

在 Redis 复制的基础上,使用和配置主从复制非常简单,能使得从 Redis 服务器(下文称 slave)能精确得复制主 Redis 服务器(下文称 master)的内容。每次当 slave 和 master 之间的连接断开时, slave 会自动重连到 master 上,并且无论这期间 master 发生了什么, slave 都将尝试让自身成为 master 的精确副本。

这个系统的运行依靠三个主要的机制:

- 当一个 master 实例和一个 slave 实例连接正常时, master 会发送一连串的命令流来保持对 slave 的更新,以便于将自身数据集的改变复制给 slave , :包括客户端的写入、key 的过期或被逐出等等。

- 当 master 和 slave 之间的连接断开之后,因为网络问题、或者是主从意识到连接超时, slave 重新连接上 master 并会尝试进行部分重同步:这意味着它会尝试只获取在断开连接期间内丢失的命令流。

- 当无法进行部分重同步时, slave 会请求进行全量重同步。这会涉及到一个更复杂的过程,例如 master 需要创建所有数据的快照,将之发送给 slave ,之后在数据集更改时持续发送命令流到 slave 。

配置文件(slave从机上配置即可)

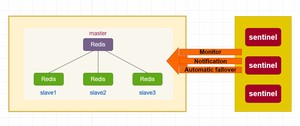

Redis 的 Sentinel 系统用于管理多个 Redis 服务器(instance), 该系统执行以下三个任务:

- 监控(Monitoring): Sentinel 会不断地检查你的主服务器和从服务器是否运作正常。

- 提醒(Notification): 当被监控的某个 Redis 服务器出现问题时, Sentinel 可以通过 API 向管理员或者其他应用程序发送通知。

- 自动故障迁移(Automatic failover): 当一个主服务器不能正常工作时, Sentinel 会开始一次自动故障迁移操作, 它会将失效主服务器的其中一个从服务器升级为新的主服务器, 并让失效主服务器的其他从服务器改为复制新的主服务器; 当客户端试图连接失效的主服务器时, 集群也会向客户端返回新主服务器的地址, 使得集群可以使用新主服务器代替失效服务器。

Redis Sentinel 是一个分布式系统, 你可以在一个架构中运行多个 Sentinel 进程(progress), 这些进程使用流言协议(gossip protocols)来接收关于主服务器是否下线的信息, 并使用投票协议(agreement protocols)来决定是否执行自动故障迁移, 以及选择哪个从服务器作为新的主服务器。

虽然 Redis Sentinel 释出为一个单独的可执行文件 redis-sentinel , 但实际上它只是一个运行在特殊模式下的 Redis 服务器, 你可以在启动一个普通 Redis 服务器时通过给定 –sentinel 选项来启动 Redis Sentinel 。

下以是当主机挂掉后,在sentinel控制台打印的日志信息

需要注意的是:

sentinel监听到master主机掉线后,会通过选举算法,产生新的master主机,并通知其它在线的从机(除刚刚被选为master的那台以外)连接到新的主机上面,所以在master和slave上的认证密码应该相同,需要在master和slave所有redis机器上面配置 ,刚刚断掉的主机如果重新启动的话,会被sentinel集群当作从机,并连接到选举产生的主机上面。同里sentinel会将现在的master监听信息固化(持久化)到自己的sentinel.conf配置文件里

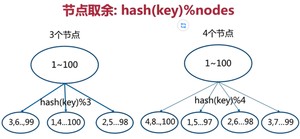

全量数据,单机Redis节点无法满足要求,按照分区规则把数据分到若干个子集当中

- 节点取余分区:

节点取余方式是非常简单的一种分区方式

节点取余分区方式有一个问题:即当增加或减少节点时,原来节点中的80%的数据会进行迁移操作,对所有数据重新进行分布

节点取余分区方式建议使用多倍扩容的方式,例如以前用3个节点保存数据,扩容为比以前多一倍的节点即6个节点来保存数据,这样只需要适移50%的数据。数据迁移之后,第一次无法从缓存中读取数据,必须先从数据库中读取数据,然后回写到缓存中,然后才能从缓存中读取迁移之后的数据 - 一致性哈希分区:

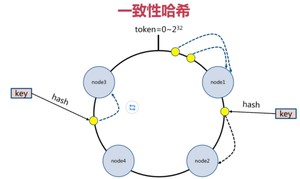

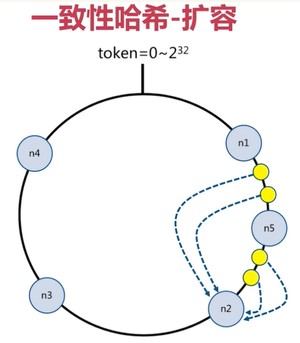

对每一个key进行hash运算,被哈希后的结果在哪个token的范围内,则按顺时针去找最近的节点,这个key将会被保存在这个节点上。

在上面的图中,有4个key被hash之后的值在在n1节点和n2节点之间,按照顺时针规则,这4个key都会被保存在n2节点上,

如果在n1节点和n2节点之间添加n5节点,当下次有key被hash之后的值在n1节点和n5节点之间,这些key就会被保存在n5节点上面了

在上面的例子里,添加n5节点之后,数据迁移会在n1节点和n2节点之间进行,n3节点和n4节点不受影响,数据迁移范围被缩小很多

同理,如果有1000个节点,此时添加一个节点,受影响的节点范围最多只有千分之2

一致性哈希一般用在节点比较多的时候 - 虚拟槽位分配:

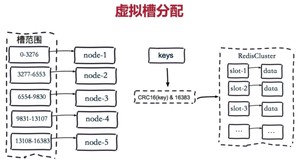

虚拟槽分区是Redis Cluster采用的分区方式

预设虚拟槽,每个槽就相当于一个数字,有一定范围。每个槽映射一个数据子集,一般比节点数大

- 把16384槽按照节点数量进行平均分配,由节点进行管理

- 对每个key按照CRC16规则进行hash运算

- 把hash结果对16383进行取余

- 把余数发送给Redis节点

- 节点接收到数据,验证是否在自己管理的槽编号的范围

如果在自己管理的槽编号范围内,则把数据保存到数据槽中,然后返回执行结果

如果在自己管理的槽编号范围外,则会把数据发送给正确的节点,由正确的节点来把数据保存在对应的槽中

需要注意的是:Redis Cluster的节点之间会共享消息,每个节点都会知道是哪个节点负责哪个范围内的数据槽

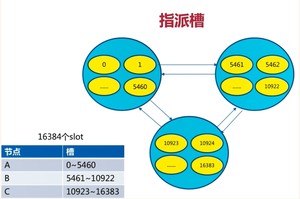

把16384个槽平均分配给节点进行管理,每个节点只能对自己负责的槽进行读写操作

由于每个节点之间都彼此通信,每个节点都知道另外节点负责管理的槽范围

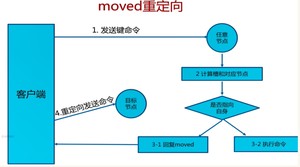

客户端访问任意节点时,对数据key按照CRC16规则进行hash运算,然后对运算结果对16383进行取作,如果余数在当前访问的节点管理的槽范围内,则直接返回对应的数据

如果不在当前节点负责管理的槽范围内,则会告诉客户端去哪个节点获取数据,由客户端去正确的节点获取数据

- 从过期字典中随机 20 个 key;

- 删除这 20 个 key 中已经过期的 key;

- 如果过期的 key 比率超过 1/4,那就重复步骤 1;

redis默认是每隔 100ms就随机抽取一些设置了过期时间的key,检查其是否过期,如果过期就删除。注意这里是随机抽取的。为什么要随机呢?你想一想假如 redis 存了几十万个 key ,每隔100ms就遍历所有的设置过期时间的 key 的话,就会给 CPU 带来很大的负载。

所谓惰性策略就是在客户端访问这个key的时候,redis对key的过期时间进行检查,如果过期了就立即删除,不会给你返回任何东西。

总结:定期删除是集中处理,惰性删除是零散处理。

- noeviction:当内存使用超过配置的时候会返回错误,不会驱逐任何键

- allkeys-lru:加入键的时候,如果过限,首先通过LRU算法驱逐最久没有使用的键

- volatile-lru:加入键的时候如果过限,首先从设置了过期时间的键集合中驱逐最久没有使用的键

- allkeys-random:加入键的时候如果过限,从所有key随机删除

- volatile-random:加入键的时候如果过限,从过期键的集合中随机驱逐

- volatile-ttl:从配置了过期时间的键中驱逐马上就要过期的键

- volatile-lfu:从所有配置了过期时间的键中驱逐使用频率最少的键

- allkeys-lfu:从所有键中驱逐使用频率最少的键

LRU:最久没有使用

LFU:使用频率最少

缓存击穿是指缓存中没有但数据库中有的数据(一般是缓存时间到期的某条),这时由于并发用户特别多,同时读取缓存没读到这条数据,又同时去数据库去取数据,引起数据库压力瞬间增大,造成过大压力

- 设置热点数据永远不过期。

- 加互斥锁,互斥锁参考代码如下

缓存穿透是指缓存和数据库中都没有的数据,而用户不断发起请求,如发起为id为“-1”的数据或id为特别大不存在的数据。这时的用户很可能是攻击者,攻击会导致数据库压力过大。

- 接口层增加校验,如用户鉴权校验,id做基础校验,id<=0的直接拦截(布隆过滤器);

- 从缓存取不到的数据,在数据库中也没有取到,这时也可以将key-value对写为key-null,缓存有效时间可以设置短点,如30秒(设置太长会导致正常情况也没法使用)。这样可以防止攻击用户反复用同一个id暴力攻击

缓存雪崩是指缓存中数据大批量到过期时间,而查询数据量巨大,引起数据库压力过大甚至down机。和缓存击穿不同的是,缓存击穿指并发查同一条数据,缓存雪崩是不同数据都过期了,很多数据都查不到从而查数据库。

- 缓存数据的过期时间设置随机,防止同一时间大量数据过期现象发生。

- 如果缓存数据库是分布式部署,将热点数据均匀分布在不同搞得缓存数据库中。

- 设置热点数据永远不过期。

版权声明:

本文来源网络,所有图片文章版权属于原作者,如有侵权,联系删除。

本文网址:https://www.mushiming.com/mjsbk/15513.html